Поделитесь вашим контентом. Начните с пункта меню "Создать". Большинство элементов в нём можно размещать без регистрации. И если Вы разместили действительно полезный контент, то после модерации он попадет на все информационные площадки Гильдии Маркетологов и в почтовые рассылки. Все размещенные материалы сохраняются и каталогизируются.

Если Вы решили создать свой блог на инфопортале, то для выделения Вам форума и получения прав модератора свяжитесь с администратором

Исследование: действительно ли уникальность контента так важна?

Инфопортал Гильдии Маркетологов :: Новости и обзоры :: Актуальные публикации для маркетолога и рекламиста :: Результаты исследований, обзоры рынков

Исследование: действительно ли уникальность контента так важна?

Исследование: действительно ли уникальность контента так важна?

Статья будет вам полезна, если вы въедливо боретесь за каждый процент уникальности контента на сайте, считая этот фактор самым важным из сотен других, применяемых поисковыми системами. Ознакомившись с проверенными гипотезами и примерами, вы освободите время на развитие сайта, вместо погони за 100 % уникальностью страниц.

Откуда началась гонка за уникальным контентом?

Изучить этот вопрос я решил осенью 2015 года, после того как мне на глаза попалась статья Дениса Савельева. Комментарии там в основном скептические, вроде «а у меня не так», «где пруфы», «покажите примеры»…Среди множества SEO-убеждений уникальность контента до сих пор занимает одно из первых мест. Когда про 100 % важность уникального контента мне рассказывает бывший одногруппник, который хочет сделать сайт – я это могу понять. Но это же заблуждение до сих пор встречается на сайтах известных компаний, сервисов:

Контент должен быть свой – это основа продвижения

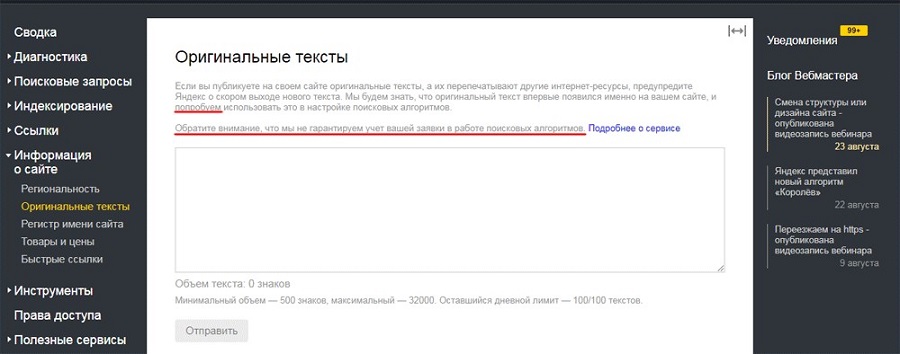

Поисковые системы тоже подливали масла в огонь – Google запустил подтверждение авторства текста через связку сайта и Google+ (на текущий момент сервис не работает). «Яндекс» добавил в «Яндекс.Вебмастер» инструмент «Оригинальные тексты». Как завсегдатай нескольких вебмастерских форумов, я видел там множество тем о том, как это важно – использовать эти инструменты.

Хотя «Яндекс» честно написал:

Попробуем, но не гарантируем

Мне даже попадалось на глаза исследование об эффективности данного сервиса. Было проверено более 15 000 статей, отправленные в оригинальные тексты. Высчитывали процент уникальности текстов и замеряли позиции – кто выше, владелец уникального текста или сайт-копипастер.

Была проделана серьезная работа

При всем уважении к проделанной в исследовании работе – даже на графиках выше видно, что 14 и 7 % сайтов, скопировавших текст, обошли первоисточник. Дальше в статье я объясню, почему так вышло.

Если долго повторять что-то – это может стать похожим на правду. Чем больше говорили об уникальности контента, тем больше теорий возникало:

- Чтобы сайт ранжировался высоко – текст должен быть уникальным.

- Чтобы получить больше трафика – картинки на сайте должны быть уникальными.

- Дизайн сайта должен быть уникальным, сайты на шаблонах высоко не ранжируются.

- Видео тоже должно быть уникальным.

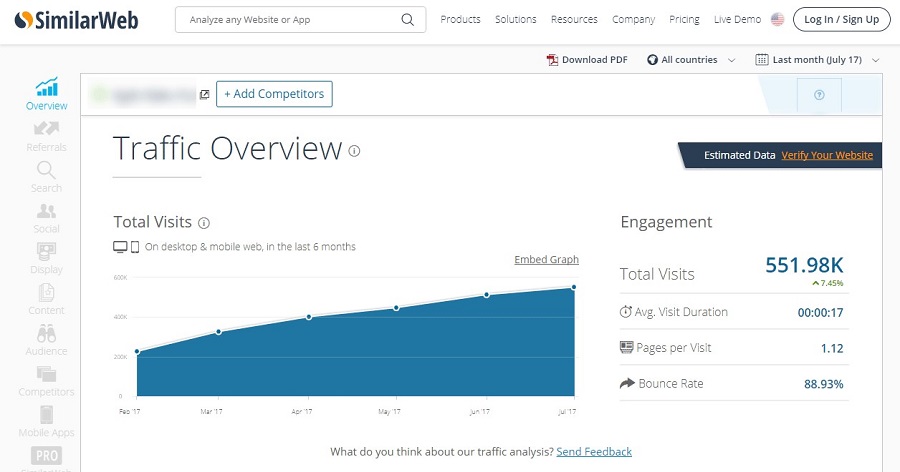

Сейчас будет небольшой спойлер о том, что три утверждения выше не совсем верны. На этот сайт я наткнулся, когда начал изучать – какой неуникальный контент «прокатит» для поисковиков. Уникальность текста на этом сайте близка к нулю – это типичный дорвей с мешаниной чужого текста:

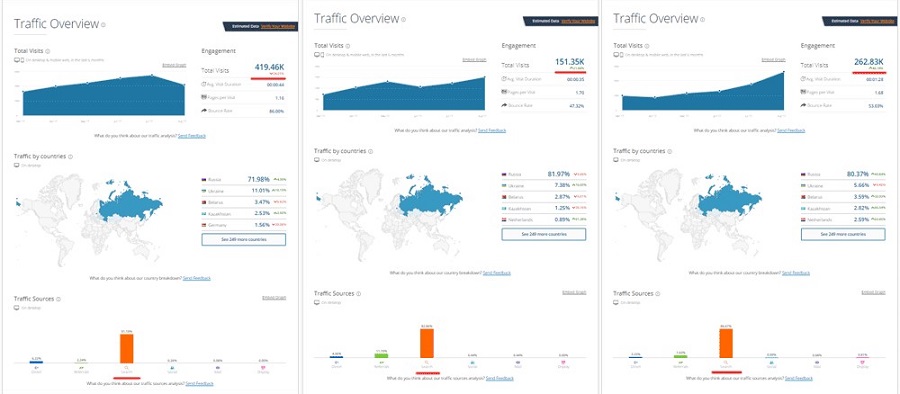

Более 90 % трафика – поисковый

Домен зарегистрирован в марте 2016 года. Как вам такой график роста посещаемости? С нуля до полумиллиона за полтора года. У вас, наверное, так же, на уникальном-то контенте?

Итак, из чего складывался миф о необходимости уникального текстового материала:

- Его подогревали текстовые биржи (что логично, это их хлеб).

- Поисковые системы в рамках одного сайта исключали из выдачи похожие страницы (считая их одинаковыми).

- Жаждущие халявы вебмастера пытались просто скопировать чужой успех – массово воруя тексты, фото. Сайты закономерно попадали под фильтры и банились поисковиками (как дубли и за отсутствие добавленной ценности).

- Сами поисковые системы заявляли о важности уникального материала и даже делали инструменты для указания первоисточника.

- SEO-блоги и рекламные агентства также почти единогласно уверяют в важности уникальных материалов.

Не на последнем месте – новизна самой веб-индустрии и некомпетентность владельцев сайтов. Почти каждый веб-специалист или веб-студия сталкивались с заказчиками, которые говорят «сделайте такой же сайт, только чтобы мой». Помимо того, что это неэтично и незаконно – это обесценивает труд специалистов. Не может же разработка сайта стоить несколько десятков тысяч (или несколько сотен тысяч) рублей, если нужно просто взять и скопировать?

Если любому заказчику показать премиум-шаблон для выбранной CMS за 70 долларов с themeforest или предложить сделать похожий (но уникальный) с нуля за 500–5000 долларов (чтобы оплатить труд дизайнера, верстальщика, программиста, проект менеджера) – выбор будет очевиден. Это также стало причиной появления еще одного заблуждения – что уникальный дизайн тоже важен (потому что если он не важен – зачем платить больше?).

Основные виды контента

В конкурентных тематиках сложно представить в топ-3 страницу, на которой размещен только текст. Обычно используются следующие материалы (по убыванию важности и по росту цены):- Текст.

- Фото. Сюда же можно отнести инфографику, иконки и т. д. Таблицы - это могут быть таблицы цен, сравнения, прайс-листы и т. д.

- Видео. Хотя видеомаркетинг с каждым годом набирает обороты, чаще встречаются страницы без видео. Это связано с дороговизной и затратами времени на производство контента.

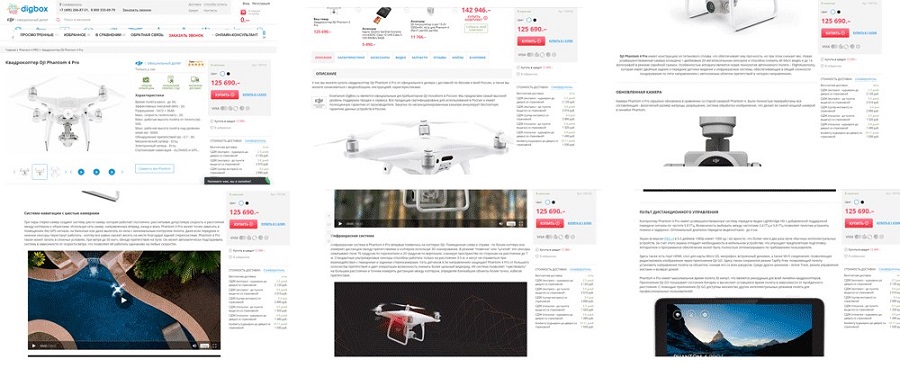

Вот пример хорошей страницы – используется все:

Это – примерно 20 % от всего контента страницы

При малых бюджетах используют текст + фото. Именно это порождает «клоны», когда вроде бы сайты разные, и контент вроде бы разный, но очень похож. Так происходит, потому что вместо цепочки:

- Определение целевой аудитории сайта.

- Первичный сбор групп интересов, отбор подходящих, анализ конкурентов.

- Структура сайта, распределение групп интересов по страницам.

- Углубленный анализ каждой группы интересов, планирование страницы.

- Создание страницы.

- Улучшение страницы после накопления статистики.

Происходит один из вариантов:

- Берем у пары конкурентов, делаем так же.

- Тексты заказываем подешевле, фотографии берем в «Гугле» или на чужом сайте.

Именно с текстом прокалывается большинство. Не то чтобы хорошего, даже неплохого копирайтинга задешево не бывает.

Потому что для получения хорошего текста нужна или заинтересованность копирайтера, или четкое ТЗ + пример «как надо делать».

Без этого за мелкий прайс заказчик (веб-студия или владелец сайта, неважно) получит в лучшем случае изложение из пары источников, а в худшем – рерайт сайта, на который наткнулся копирайтер. И это не потому, что копирайтеры плохие. А потому, что каждый человек хочет достойно зарабатывать. Для дешевого заказа с непонятным техническим заданием вникать в тему, составлять план статьи, подбирать классные источники, определять ЦА за заказчика никто не будет.

Название компании можно взять любое – ничего не изменится

Примеры страниц, где используются одни и те же фотографии вы наверняка видели. «Хорошим» тоном на сайте про ремонт, дизайн или строительные услуги считается размещение фото с первой-второй страницы поиска по изображениям:

Так и вижу всех этих ребят на стройке у соседа

И при всем этом в рунете идет беспощадная битва за уникальность контента. Пусть текст плохой – зато уникальный. Пусть картинка не к месту – но ее развернули, обрезали, поменяли тона – и она тоже уникальна.

Примеры коммерческих ниш и сайтов с неуникальным контентом

Чтобы понять, что роль уникального контента преувеличена, достаточно изучить коммерческие сайты в однотипных нишах, особенно интернет-магазины с большим количеством позиций. Если сравнить содержимое карточек товара для технических товаров – окажется, что данные почти идентичны:- Технические характеристики одинаковы.

- Фотографии могут быть одинаковыми (если производитель разрешает использовать их).

- Если товар – не хит, отзывов не будет, или будет мало.

- Описание – в лучшем случае рерайт с официального сайта с очень низкой текстовой уникальностью.

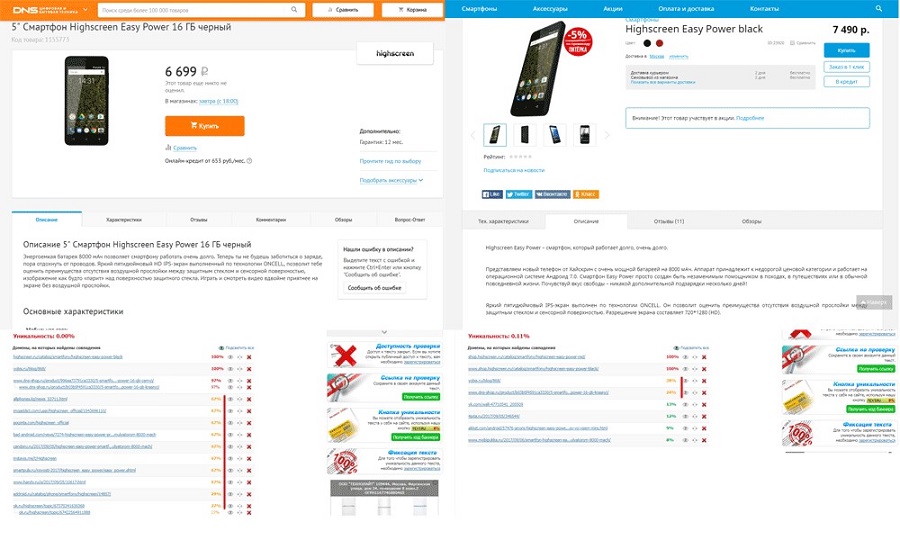

И это абсолютно не мешает сайтам занимать топ:

Описание на 30–90 % совпадает с текстами на других сайтах

Таких примеров вы можете найти сколько угодно, особенно в тематиках, где и написать-то нечего. Сложно придумать уникальное описание для:

- строительных материалов (гипсокартон, гвозди, сантехническая фурнитура, металлическая сетка и т. д.);

- товаров для рукоделия (нитки для шитья, вязания, картины по номерам, бисер, крючки для вязания, наборы иголок, ткани и прочее);

- рыболовных аксессуаров (крючки, воблеры, шнуры, грузила, другие товары).

А теперь представьте, что товарных позиций в интернет-магазине более 100 000, а категорий – более 500. Даже при автоматизированном создании описаний по шаблонам – это колоссальный объем работы. Поэтому большинство интернет-магазинов продвигает категории, не заморачиваясь над уникальностью товарных карточек (которые могут давать более 50 % трафика, хотя не отличаются от конкурентов даже на 10 %).

И это не мешает их владельцам выедать мозги копирайтерам за лишних 3 % уникальности по адвего, etxt, text.ru или их аналогам.

Другие виды сайтов

Если сайт наполняется силами одной компании, можно как-то следить за уникальностью. А как же сайты, где материалы создаются пользователями? Вот примеры UGC сайтов, которые преспокойно живут не заморачиваясь:- Доски объявлений.

- Каталоги недвижимости, организаций.

- Сайты по поиску работы/вакансий.

- Сервисы вопросов-ответов.

- Форумы.

- Казуальные сайты, которые публикуют одни и те же мемы, истории и т. д.

- Новостные сайты.

- Агрегаторы любого типа (нулевая уникальность, сайт собирает данные с других сайтов).

- Картографические сервисы.

Думаю, вы и сами можете найти еще примеры, где контент один и тот же – а сайты собирают хороший трафик. Интересные примеры можно оставить в комментариях.

Три моих эксперимента по созданию сайта с нулевой или минимальной уникальностью

Как я писал ранее, эти мысли у меня появились осенью 2015 года.Сайт № 1

В октябре 2015 был зарегистрирован домен и создан сайт на 30 страниц. Проект делался без технического SEO, т. е.- сайт не был добавлен в инструменты для вебмастеров «Яндекс» и «Гугл»,

- служебные страницы не были закрыты от индексации,

- юзабилити было на уровне «бесплатный шаблон бесплатной CMS» без правок,

- метатеги автоматически генерировались движком сайта,

- источником контента были трафиковые страницы популярных сайтов, отобранные через сервисы анализа конкурентов (т. е. с большим трастом, с кучей ссылок, и т. д.).

Гипотеза была следующей – для поисковика важна добавленная ценность. Поэтому для каждой страницы было написано что-то вроде выжимки – о чем контент, чем будет полезен пользователю. Затем шел контент из источника + ссылка на первоисточник.

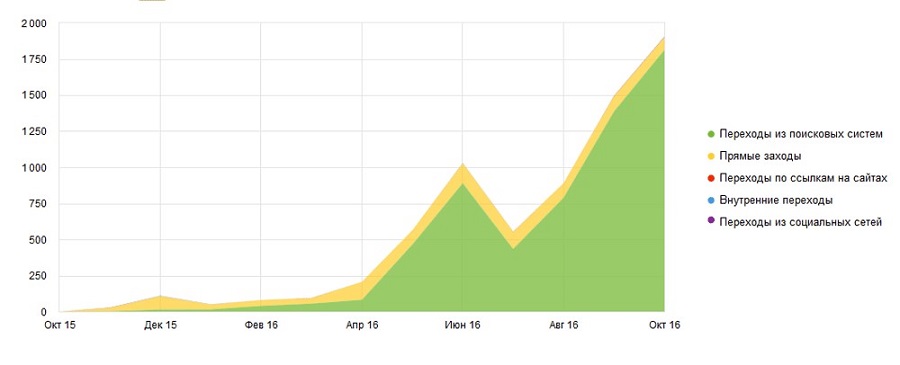

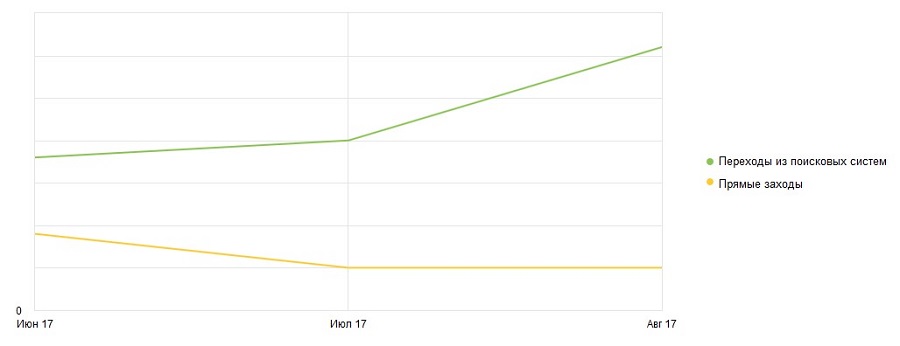

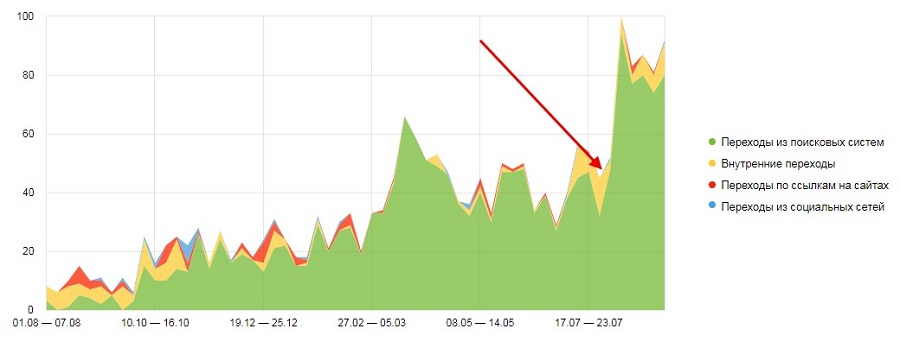

После этого про сайт я забыл и вспомнил только при напоминании о необходимости продлить домен. Вот что получилось по посещаемости на первый год жизни сайта:

С 0 до 60 человек в сутки за 1 год на 30 страниц

Каждая из страниц содержала около 5 % уникального контента – а именно, вступление. Результаты меня воодушевили, было решено продлить домен и дать отстояться еще. В феврале 2017 я решил расширить эксперимент. Вместо поиска трафиковых статей трастовых тематических сайтов – собирались все материалы по какому-либо вопросу, связанному с финансовой отчетностью. Ниша конкурентная, полезные и актуальные материалы нужно искать по крупицам. Что было сделано:

- Находились группы интересов по теме проекта.

- Под каждую группу создавалась страница, которая содержала вступление, максимально полную информацию по какому-либо вопросу со ссылками на источники.

- Все SEO-пункты, не сделанные на старте, были сделаны.

Если в 15-16 годах количество уникального контента для каждого документа было около 5 %, то теперь оно упало до 1-2 % и менее. Не текстовый контент также был неуникальным. С февраля по апрель было добавлено около 70 страниц, посещаемость сайта выросла в 2,5 раза.

Рост с 65 до 165 посетителей в сутки за 2 месяца

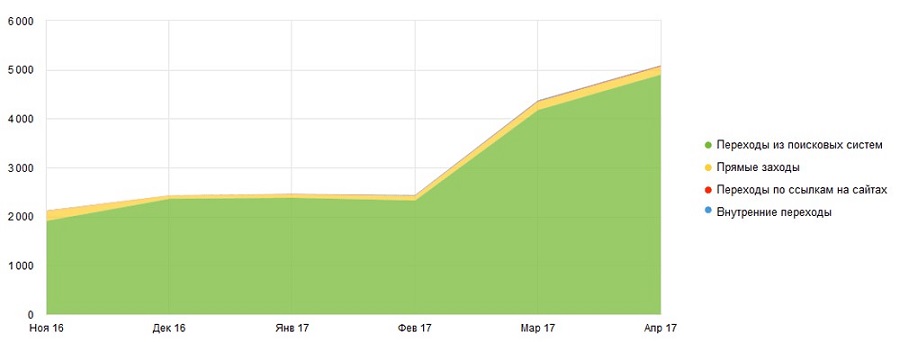

В мае я решил проверить, насколько важно хотя бы разовое вхождение текстового запроса:

- В метатеги (title и description).

- В H1

- В заголовки уровня H2-H6 и текст страницы.

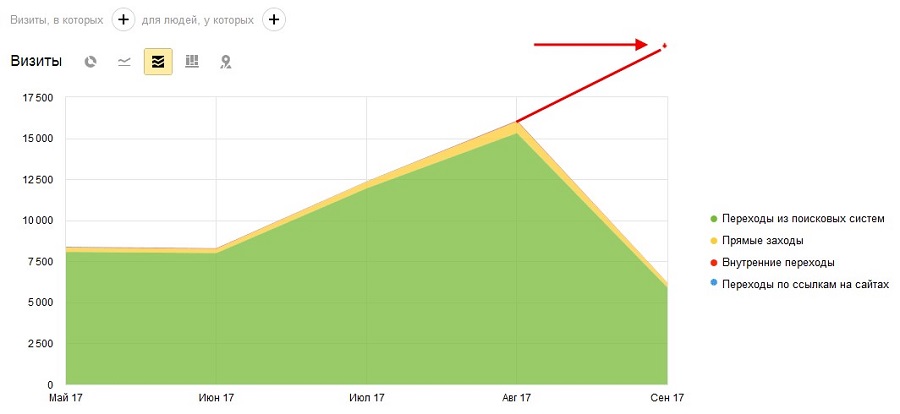

На сайт был установлен модуль проверки семантики. К полуторалетнему юбилею сайту было составлено семантическое ядро, запросы с помощью модуля были вписаны на страницы. Несмотря на летний спад в нише, май-август дали рост трафика еще в 3+ раза от апрельского. А судя по графику роста – в сентябре сайт пробьет цифру в 20 000 по посещаемости.

Прогноз роста на сентябрь

На мой взгляд – рост посещаемости и отличные поведенческие факторы (менее 10 % отказов, более 5 минут времени на сайте) уже показали, что уникальность – не самый важный показатель.

Но мое мнение – личное, а я хотел узнать, что думают о сайте поисковые системы. Каким способом можно добиться ручной проверки качества сайта представителями поисковиков? Подав сайт на участие в «Рекламную сеть Яндекса» и Google Adsense.

Сайт был принят в обе рекламных системы. Особый шик в том, что сайт размещался в новом аккаунте, т. е. проходил более глубокую проверку. Судя по всему, до конца года сайт преодолеет порог в 1000 посетителей в сутки и продолжит расти.

Какие выводы по этому проекту:

- В 2015 году достаточно было минимальных усилий, чтобы получить посетителей.

- Новый актуальный (актуальный, а не уникальный) контент на сайте дает прирост трафика, если у сайта хорошие поведенческие.

- Рост в 2017 произошел во многом благодаря истории домена – накопленным поведенческим и узкой нише.

- «Просто улучшайте ваш сайт» работает в разы хуже, чем «Просто улучшайте ваш сайт, но не забывайте про полноту раскрытия темы, SEO и семантику».

- Поисковые системы не считают уникальность контента краеугольным камнем.

Причины, по которым сайт получал, получает и будет получать посетителей и дальше – хорошие поведенческие, которые формируются:

- благодаря оформлению страниц – крупный шрифт, читабельное оформление, фото, видео, инфографика и другие данные, которые дают пользователю всю информацию;

- потому что все страницы – лонгриды, при прочих равных время и глубина просмотра выше, т. к. даже для беглого просмотра страницы нужно больше времени;

- самое главное – ответ на все вопросы пользователя в одном месте.

По опыту работы с другими сайтами – пик посещаемости достигается за 6–12 месяцев, в зависимости от качества страницы и конкурентности тематики. Т. е. к марту 2018 года прогнозная посещаемость – около 2 000 посетителей в сутки. Это в 30 раз больше, чем было в феврале 2017.

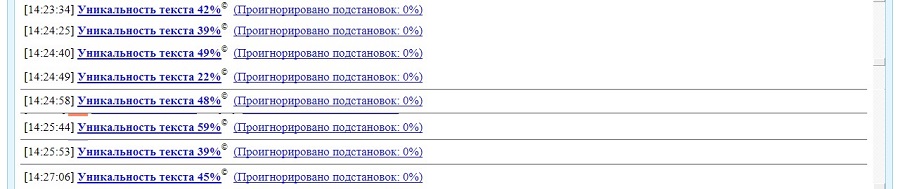

Еще одно небольшое открытие, которое я сделал при написании этой статьи – контент со временем наращивает текстовую уникальность. Полгода назад только 3-4 материала могли похвастаться уникальностью выше 3, но менее 10 %. Сейчас более половины текстов набирают такие показатели:

И так у 50+ страниц из 100

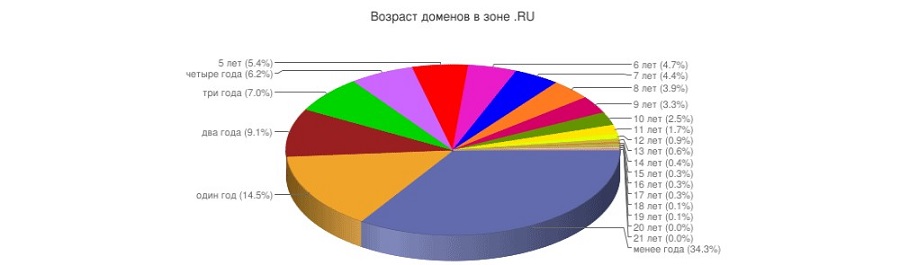

Причина лежала на поверхности:

Только 40 % доменов имеют возраст более 3-х лет

Часть доменов, которые были источниками – не были продлены, контент был удален. Если посмотреть на диаграмму и предположить, что в будущем данные изменятся незначительно – окажется, что шанс контента стать уникальным через два года – около 60 %.

Сайты № 2 и 3

В связи с успехом эксперимента № 1, было решено проверить – получится ли повторить это в сегодняшних реалиях? Были выбраны 2 конкурентных ниши – строительство и юридические услуги.Оба сайта изначально делались с учетом первого эксперимента:

- Была подобрана семантика для каждой из страниц.

- Был подобран бесплатный, но удобный адаптивный шаблон.

- Сайт не имел ошибок, мешающих индексированию (попаданию страниц в результаты поиска) и ранжированию.

- Все материалы – лонгриды, полностью закрывающие запрос пользователя.

- Уникальность контента менее 3 %.

На каждом из проектов было размещено по 10 страниц.

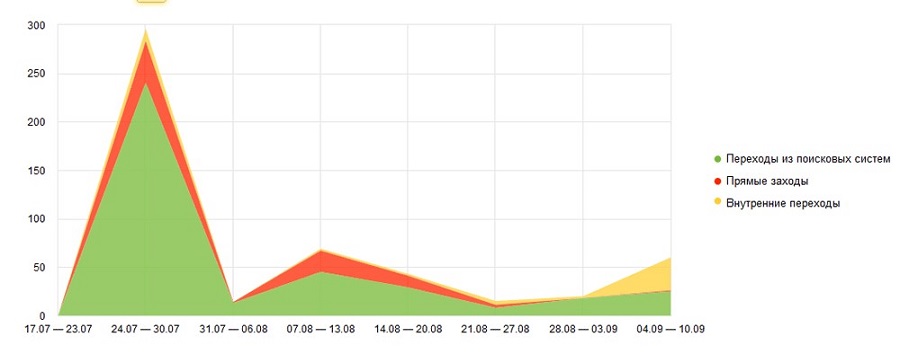

У обоих сайтов наблюдался интересный эффект – при нулевом количестве страниц в индексе «Яндекса» – всплеск посещаемости из этого поисковика. Связано это скорее всего с «подмешиванием» страниц новых сайтов в выдачу для оценки поведения пользователей.

На юридическом сайте всплеск виден более явно

После попадания в индекс страницы участвуют в поиске «на общих основаниях», что приводит к падению посещаемости. Дальнейшая динамика такая же, как на сайте № 1. Первые 3-4 месяца идет накопление статистики и незначительный рост количество посетителей.

В ноябре-декабре ожидается рост в 2-5 раз

Другие проекты 2016 – 2017 годов (со 100 % уникальным контентом), которые я считаю успешными, имеют похожие графики – начальный трафик, спад во второй месяц, рост в 3–6 месяцы.

Начиная от полугода жизни сайт вырастает по трафику в несколько раз и продолжает расти, если продолжать его развивать.

Какие выводы можно сделать:

- Принципиальных изменений в ранжировании неуникального контента за последние 2 года не произошло.

- Динамика роста – такая же, как и на 100 % уникальных сайтах.

- Для новых направлений желательно готовить сайты-заглушки на 5–50 страниц и дать им отстояться 3–6 месяцев и более – это поможет ускорить развитие проекта в будущем.

Ближе к концу года в комментариях к статье я постараюсь разместить графики по всем трем проектам, чтобы посмотреть – насколько мои ожидания совпадут с реальностью.

Сайт № 4

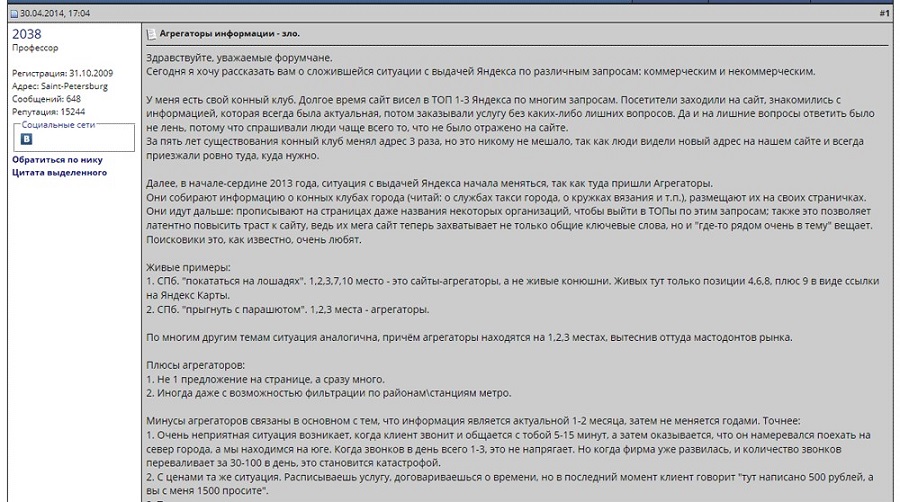

Это как раз сайт-заглушка на 50 страниц. Контент не уникальный, сайт – узкотематический справочник. На вебмастерских форумах и SEO-блогах десятки раз обсуждалось, что каталоги и агрегаторы в выдаче занимают топ, выкидывая оттуда сайты компаний. Но личный опыт всегда лучше, чем чужой. В августе 2016 был зарегистрирован домен, на нем разместили около 50 страниц.

Одна из тем на searchengines

Какие гипотезы нужно было проверить:

- Как на развитие проекта повлияет наличие заглушки (т. е. определение поисковиками тематики проекта и накопление данных о поведении пользователей).

- Через какое время сайт в выдаче начнет «задвигать» сайты компаний.

- Можно ли забрать у компаний часть брендового трафика.

- Что лучше – развитие проекта «под запросы» или «под нишу».

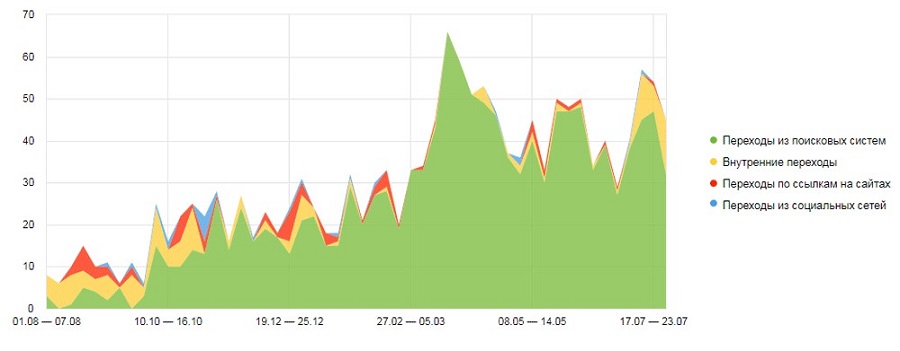

Первый год жизни проекта – ничего особенного. Самым сложным было собрать информацию и представить ее в едином виде. По правде говоря, я не думал, что проект будет хоть как-то расти на тех 50 страницах, залитых в августе 17-го. Я ошибся:

Справочник собрал около 2 % всего трафика в нише

Если отбросить все информационные запросы в нише, основные коммерческие запросы ищут от 15 до 30 тысяч человек в месяц в России в целом. Ниша конкурентная – более 1000 компаний предлагают свои услуги. Цена привлечения клиента – сумасшедшая, в контекстной рекламе более 100 рекламодателей.

И «сделанная на коленке» заглушка собирает около 200 посетителей в месяц (привлечение такого кол-ва посетителей через рекламу обошлось бы в 200–500 долларов).

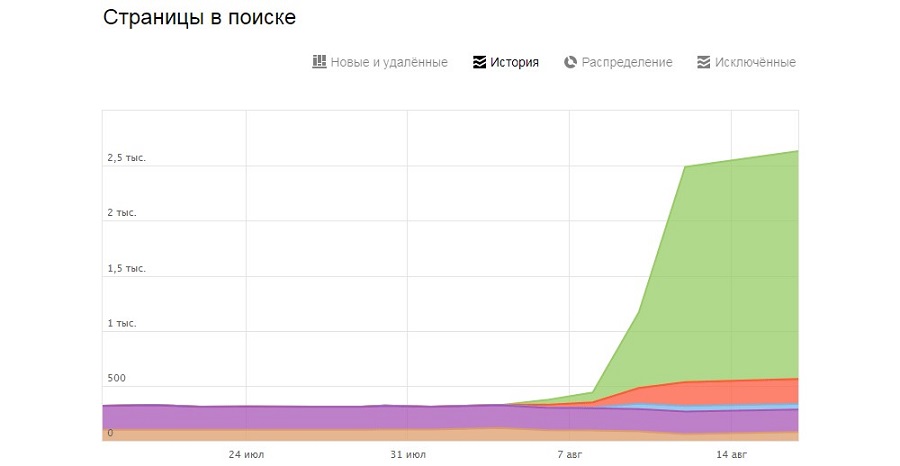

В августе 2017 были собраны данные по основным компаниям, на сайт было добавлено более 2 000 страниц.

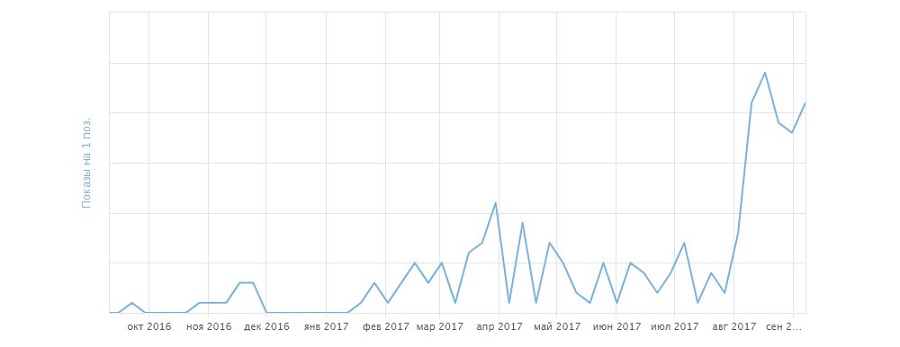

График роста страниц в поиске

Оказалось, что помимо 50 страниц используемая CMS сгенерировала более 400 страниц в виде rss-фидов, версий для печати, pdf-версий и прочего мусора, который обычно из индекса выкидывают сами поисковики, если этого не сделал вебмастер.

Все гипотезы получилось проверить через неделю после попадания страниц в индекс.

Как наличие заглушки (т. е. определение поисковиками тематики проекта и накопление данных о поведении пользователей) повлияет на развитие проекта:

- Даже в очень конкурентной нише еще один сайт соберет свою долю посетителей.

- Если сайт не имеет хорошие поведенческие – его посещаемость будет расти (несмотря на отсутствие новых материалов).

- Новые страницы быстро попадают в индекс поиска и собирают трафик.

Вот рост посещаемости сразу после добавления новых страниц:

Астрологи объявили неделю индексации. Посетители из поиска удвоились.

Сайт, который делался как эксперимент – начал собирать около 5 % всех посетителей в нише. Переходим к следующему пункту – через какое время сайт в выдаче начнет «задвигать» сайты компаний?

Сразу после добавления новых страниц сайт начал с позиций 10–50 попадать в топ-3, чаще всего на первую позицию:

Данные «Яндекс.Вебмастера»

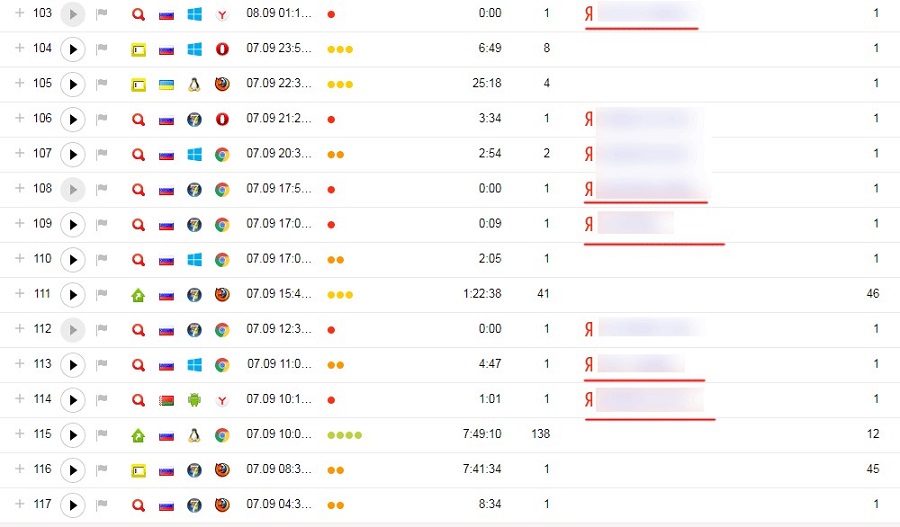

В Google аналогичная картина, но в основном сайт занял с 3-ей по 10-ю позиции. Это не помешало сайту забрать часть брендового трафика:

Красным подчеркнуты брендовые запросы

И последняя гипотеза – что лучше, развивать проект под запросы пользователей или под нишу в целом? Однозначно, лучше делать проект, закрывающий все возможные группы интересов. 2000+ страниц, которые были добавлены в августе, отбирались по принципу «берем все, что могут искать хотя бы раз в несколько лет».

Этот подход оправдал себя полностью. Если этот проект будет развиваться по той же кривой, что и другие – на пик трафика он выйдет как раз весной-летом 2018, к новому сезону. По моему прогнозу – по посещаемости он будет отставать только от лидеров ниши с миллионными бюджетами на онлайн и офлайн маркетинг с сайтами, которые динамично развивались с 200х годов.

В цифрах – около 20 % трафика в нише по пессимистичному прогнозу.

Какие выводы можно сделать из этого эксперимента:

- Тематические справочники (каталоги, агрегаторы) по прежнему обходят в выдаче авторитетные сайты компаний, несмотря на мизерную уникальность.

- Главное – думать как пользователь, и дать ему нужную информацию.

- Чтобы делать такие сайты, нужно уметь искать и структурировать данные.

- Ни одной ссылки куплено не было, но реферальный трафик есть – посетители расшаривают полезный сайт.

За август несколько новых компаний попросились в справочник, поинтересовались возможностью размещения рекламы и посещаемостью. Проект никак не рекламировался. Рискну предположить, что нашли его в выдаче, а добавиться решили, «потому что наши конкуренты там есть».

Небольшой бонус для любителей почитать

Ни этот сайт, ни один из конкурентов в нише, не использует методику, которая в западной seo-тусовке называется «silo architecture», а у нас – тегированием. Это обширная тема, я рекомендую прочитать статью, чтобы в ней разобраться. Вкратце – создавайте новый контент на основе имеющихся данных и показывайте его целевой аудитории. Примеры:

- На сайте по аренде недвижимости для каждого объекта указать ближайшую школу/ВУЗ и создать страницы «Снять N-комнатную квартиру возле NN школы».

- Для строительной компании – вывести портфолио не пачкой фотографий, а страницами «дизайн и ремонт небольшой студии», «перепланировка квартиры в студию» и т. д.

- В комментариях вы можете написать свою нишу, а я попробую подобрать несколько вариантов для вас.

Вот пример в конкурентной теме, где ни каталоги, ни сайты производителей не заморачиваются над такой мелочью, как интересы своих клиентов:

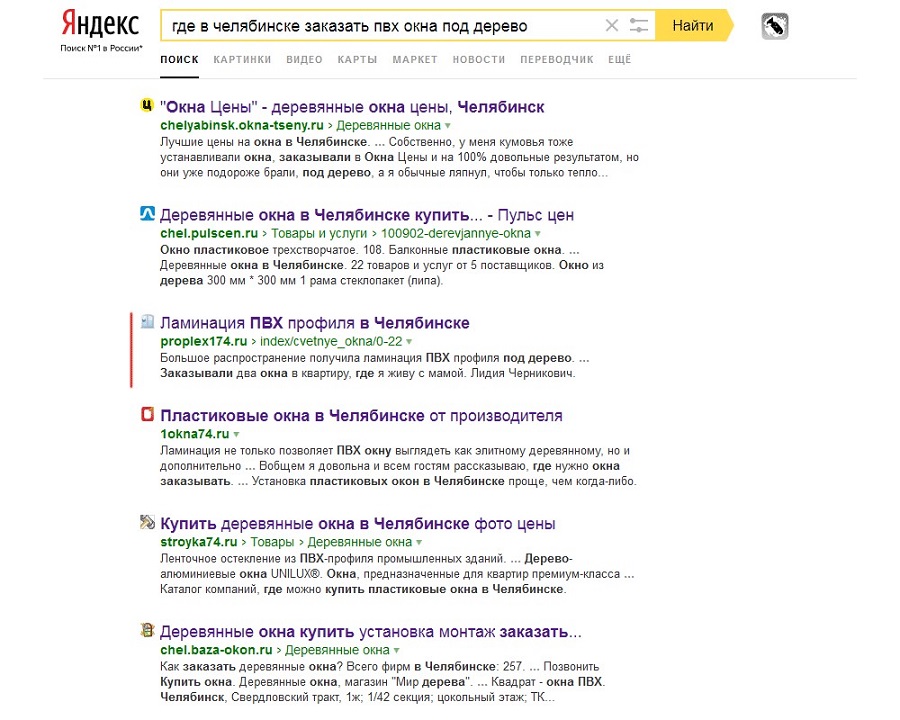

Справочник со страницей «ПВХ окна под дерево в Челябинске» обошел бы всех

На первой странице – только один сайт хоть как-то дает понять, что нужная услуга предоставляется компанией. И это при том, что полная имитация «под дерево» (с ламинацией торцов створок) дает наценку от 20 до 50 % на окно.

Так вот, возвращаясь к проекту «справочник на неуникальных данных», я даже не могу предположить, какую часть потенциальных клиентов можно увести на свой сайт, добавив такие страницы. Время покажет, а вы можете узнать...

См. продолжение статьи

Последний раз редактировалось: Admin (Ср 11 Окт 2017, 03:16), всего редактировалось 1 раз(а)

Admin- Admin

- Дата регистрации : 2016-02-14

Сообщения : 836

Репутация : 17

Продолжение

Продолжение

В каких случаях контент может быть неуникальным и почему за это не будет никаких санкций со стороны поисковых систем

Сначала разберем текстовую составляющую страниц, а затем изображения и видеоконтент. Текстовая уникальность проверяется по шинглам. Т. е. весь текст делится на фрагменты (обычно от 3 до 10 слов) и проверяется – не встречается ли эти 3 (4, 5, 10) слов в таком же порядке на других сайтах.Например, текст с фразой «международный день защиты детей» не может иметь уникальность 100 % по шинглу 4, т. к. это словосочетание сотни тысяч раз встречается на форумах, новостных сайтах, календарях и т. д.

При этом в сотнях ниш текстовый контент может быть только неуникальным. Вот несколько первых пришедших в голову примеров:

Тексты законов, судебных решений, юридических формулировок, цитат из них. Нельзя просто взять и сделать рерайт Гражданского Кодекса или всех решений арбитражных судов Московской области. Сайты и сервисы вопросов-ответов с переводом с юридического на человеческий неоднократно цитируют законы, подзаконные акты, судебную практику по аналогичным делам. Это неуникальный контент? Да. Сайты за это забанили или понизили в выдаче? Нет.

Онлайн-библиотеки. По сути все различие подобных сайтов – количество книг, их разбивка (вся книга на одной странице, или по 10 000 слов на страницу), возможно – форумы, списки лучших и т. д. В рамках большого сайта >99 % контента (тексты книг и стихов) неуникальны? Да. Такие проекты показываются в поисковой выдаче и получают оттуда посетителей? Да. Стали бы вы читать стихи Пушкина в рерайте с повышенной уникальностью? Нет.

Тексты и переводы песен. Даже если предположить, что все переводы в рамках сайта не будут скопированы на другие аналогичные проекты, то исходный текст песен останется. Получается, такие сайты не могут похвастать уникальностью выше 50 % и оцениваются по другим параметрам – удобство, поведение пользователей, количество песен. Может быть, только один сайт с текстами песен остался в топ-1, а остальные все попали в черный список «Яндекса» и «Гугла»? Нет.

Справочная информация, которая является неизменной. Или редко устаревающей. Почтовые индексы, расстояние между населенными пунктами, курсы валют и акций за прошлый год и т.д. Сотни сайтов предлагают одну и ту же информацию? Да. Каждый из них получает свою долю посетителей? В основном, да.

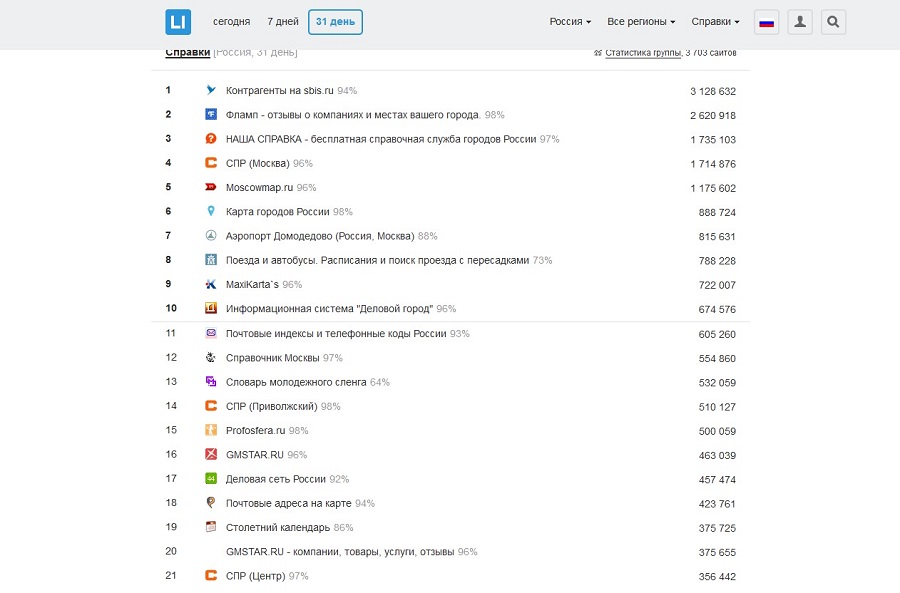

Больше примеров можно найти в любом рейтинге в разделе «Справки»:

Рейтинг лайвинтернета

Получается, что несмотря на обилие примеров сайтов с мизерной или нулевой уникальностью – миф о ее важности продолжает жить и расти, причем не только для текстов.

Уникальность графического контента (фото, изображения, инфографика и т. д.) нужна для привлечения трафика по изображениям, но никак не влияет на сайт в целом. Да и для получения «картиночного» трафика нужно помимо наличия авторских изображений оптимизировать теги alt и title, текст около изображения и саму страницу.

Со стороны поисковых систем к сайтам, использующим неуникальные изображения, никаких автоматических санкций или фильтров не применяется. О рисках использования чужих изображений я расскажу чуть позже.

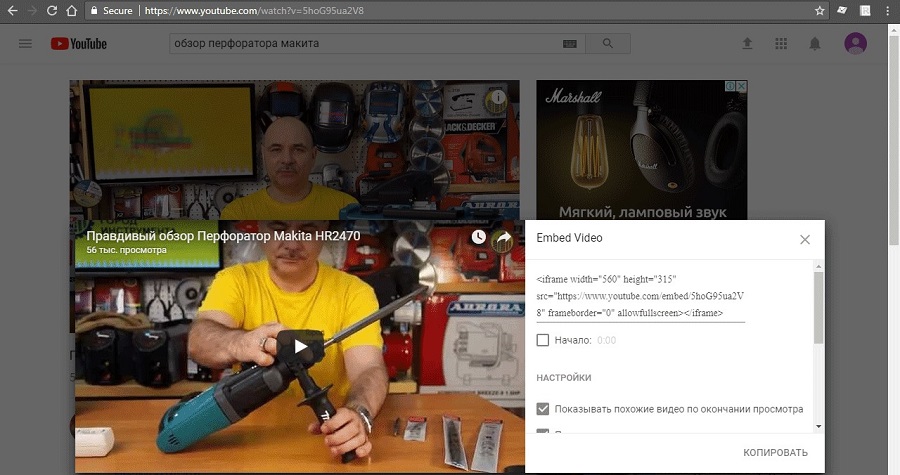

Так же дела обстоят и с видеоконтентом. Будет это авторское видео или ваше личное – никакой разницы для ранжирования сайта нет.

Ютуб разрешает встраивать видео, если автор ролика не против

Если бы поисковик был против размещения не авторского контента на страницах сайтов, то и в своем сервисе такой функционал не предлагал бы.

Добавленная ценность

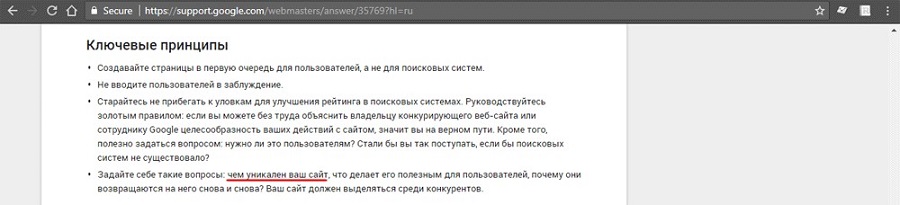

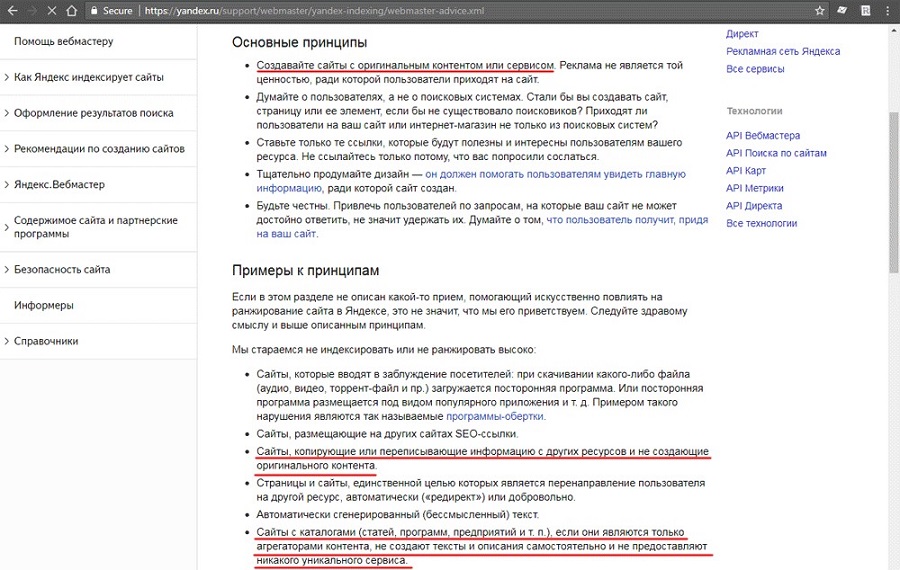

Давайте посмотрим, какие ключевые принципы у лидирующей в мире поисковой системы?

Вы видите здесь проценты уникальности текста или что-то похожее?

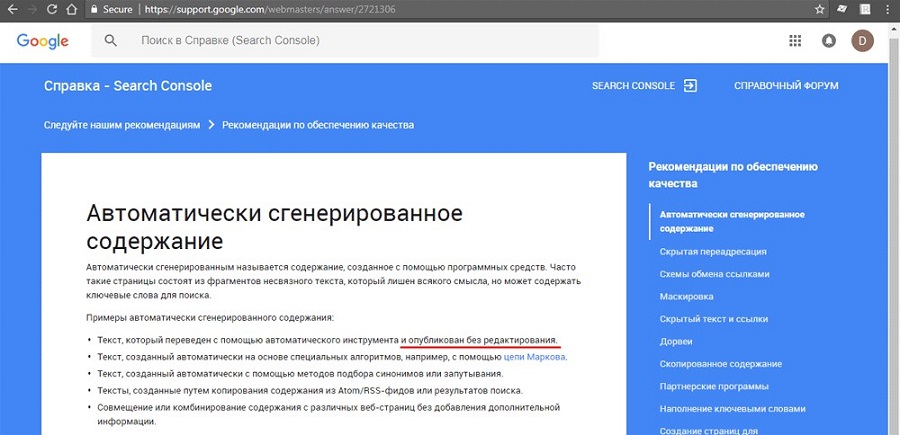

Даже для самых ненавидимых всеми генерированных сайтов, которые под горячую руку называют дорвеями или ГС-ами, есть свой свод правил:

С редактированием – генерируйте на здоровье

Вот что владельцам сайтов предлагает «Яндекс»:

Все должно быть оригинально, иначе сайт не будет ранжироваться высоко

Проблема в том, что справка «Яндекса» не дает определения оригинальности или уникальности, которое можно измерить в какой-нибудь метрической системе. Вы не найдете определений вроде «Уникальным считается контент, который в исходном коде страницы занимает не менее N % в символах, имеет уникальность не менее NN %, произвести замеры можно с помощью сервиса XYZ». Фактически, это голословные рекомендации, проиллюстрировать которые можно следующим изображением:

Сайты, не создающие оригинального контента

Мой личный опыт и анализ разных сайтов показывает, что «оригинальность» скорее стоит понимать как «изюминку» или «фишку» проекта, а не как «текстовую уникальность 96 % и выше по такому-то сервису».

Я не буду называть какие-то конкретные домены. Вы можете сами найти как сайты, копирующие и переписывающие информацию с других сайтов, так и сайты, которые являются только агрегаторами контента, и при этом собирающие от 1 000 до 15 000 посетителей в сутки.

Гораздо важнее удобство пользователя, чем оригинальный контент. А удобство пользователя создается с помощью добавленной ценности, которая выражается абсолютно по-разному.

1. Удобство потребления контента

Если вы возьмете востребованный контент (например, адреса избирательных участков с сайта ЦИК) и приведете их в удобный вид с поиском по адресу – это не будет уникальный контент. Но он будет удобнее, чем это:

UI дизайнер у вас так себе

Возможно, вы когда-то читали книги онлайн или искали тексты (или переводы) песен. В таком случае, скорее всего у вас был любимый сайт, на который вы заходили, минуя поиск. Заходили из-за удобства, а не из-за уникальности контента.

2. Объединение данных из разных источников в единый формат

К таким сайтам можно отнести любые агрегаторы – от каталога отелей Сочи до агрегатора обменников электронных валют.

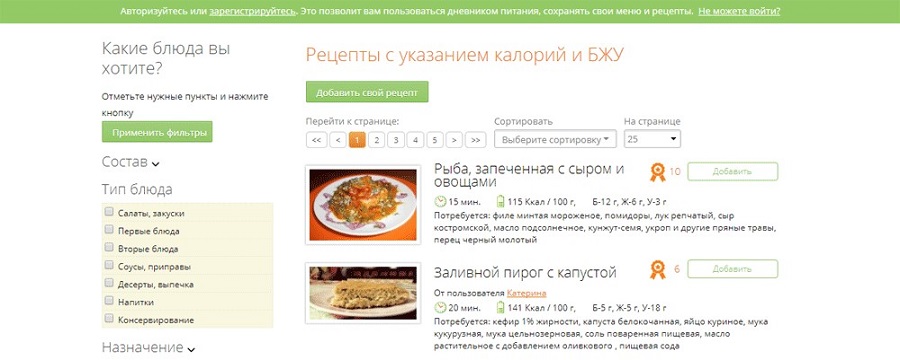

3. Компиляция данных

Простейший пример – сайт рецептов, где кроме ингредиентов указана калорийность, белки-жиры-углеводы, время приготовления.

Какой контент здесь основной?

Барышне, которая высчитывает калорийность и отмеряет порцию на весах, важнее калорийность блюда, а не уникальность рецепта. Ей вообще может быть не нужен рецепт.

4. Сервисы, которые на неуникальных данных формируют добавочную ценность

Простой пример – примерная стоимость владения автомобилем, с учетом:

- ежегодного удешевления его стоимости за N лет;

- затрат на топливо при ежегодной езде M километров;

- оплаты парковки X дней в месяц по Y денег;

- расходов на страховку при стаже водителя P лет.

Будет ли такой сервис востребован? Скорее всего, да. Можете найти что-то похожее? Я при беглом поиске не нашел. Хоть какие-то данные здесь будут уникальны? Нет, это простой расчет по формулам.

5. Просто полнота информации

Например, SEO-специалиста может интересовать, как закрыть результаты фильтрации товаров интернет-магазина для поисковых систем через robots.txt. Во-первых, в поиске в топ-10 будут также и страницы, которые содержат ВСЕ директивы, возможные в robots.txt, включая нужную. Во-вторых, все эти статьи совпадают на 10–90 %, т. к. примеры команд будут или одинаковыми, или очень похожими. В-третьих, скорее всего пользователь зависнет на странице с максимумом примеров (а вдруг что-то полезное еще будет), а не на самой уникальной.

6. Вовлечение пользователей

Если на двух разных сайтах, содержащих одинаковый контент (например, один из законов РФ), на одном сайте на вопросы пользователей будет отвечать юрист, а на другом не будет возможности оставить комментарий – какой сайт вы предпочтете? Здесь можно возразить, что комментарии и есть уникальный контент, и это правда. Но изначально оба сайта в равной позиции. Хотя бы потому, что законы РФ содержатся не на двух, а на сотнях сайтов, и стартовая уникальность будет практически нулевой у обоих проектов.

Другой пример – наличие видео по теме страницы. Перефразируя пословицу, «лучше 1 раз увидеть, чем 100 раз прочитать», особенно если текст такой же понятный, как этот:

Пожалуй, посмотрю видео

Т. е. если взять руководство по эксплуатации и ремонту автомобиля, разложить его на страницы и на каждую добавить тематическое видео – это будет хороший и полезный сайт. С нулевой уникальностью (и текст и видео не авторские), но отличными поведенческими факторами.

7. Кто первый встал, того и тапки

Это, в основном, актуально для новостного или событийного контента. Сайт, который быстрее набирает посетителей на новые страницы – будет получать львиную долю посетителей. При этом источником первоначального трафика могут быть соцсети, ютуб, развлекательные сайты.

Для этого пункта еще очень важную роль играет кликабельность в выдаче. Если сайт-первоисточник имеет пресный сниппет, а сайт, скопировавший страницу, сделает кликабельный тайтл, использует микроразметку – уникальность контента не будет играть никакой роли. Потому что пользователь будет в поиске переходить не на первоисточник, а на копию. Дополнительно добавляя вес копии, если это будет последний клик в выдаче.

8. Объем данных

Простой пример - сайт с 50 000 текстами песен, соберет больше посетителей, чем сайт с 500. Это особенно хорошо видно в некоммерческих и казуальных нишах (онлайн-библиотеки, флеш-игры, и т. д.) – сайты-лидеры аккумулируют больше контента. Не больше уникального контента, а больше страниц в принципе.

В коммерческих нишах хорошим примером выступают интернет-гипермаркеты. В каком-то узком сегменте (палатки и спальники) они проиграют тематическому магазину с туристическим снаряжением, но в целом будут получать в сотни и тысячи раз больше посетителей и прибыли. Хотя описания товаров могут совпадать на 30–100 %.

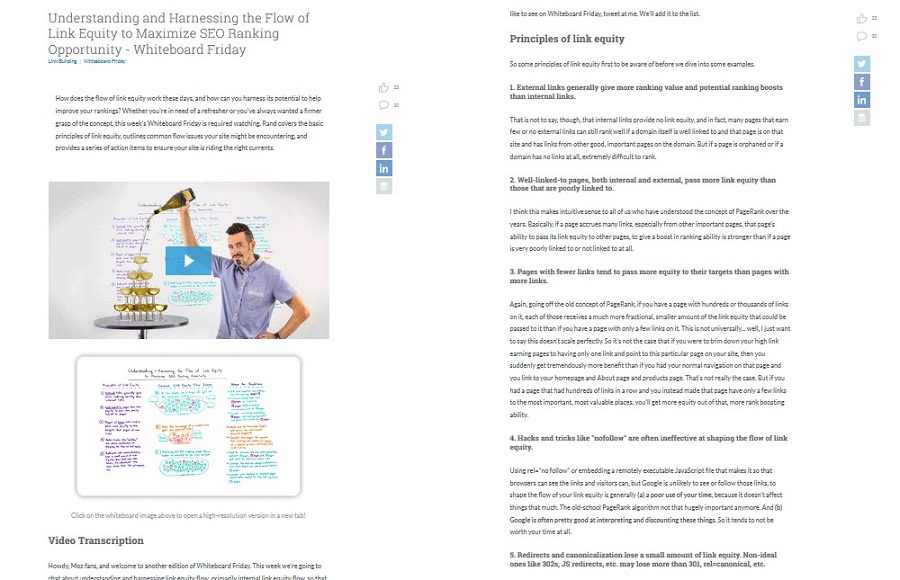

9. Смена формата контента

Из ролика можно вытянуть субтитры и дополнить все это кадрами из него – и получить уникальный контент. Так поступают в MOZ, размещая транскрипцию видео в текстовом формате.

3 формата подачи контента

По такому же принципу работают различные видеосайты – подбирая тематические видео и добавляя к ним описание. Есть и более «паразитирующие» сайты, которые дают добавленную ценность только поисковикам. Например:

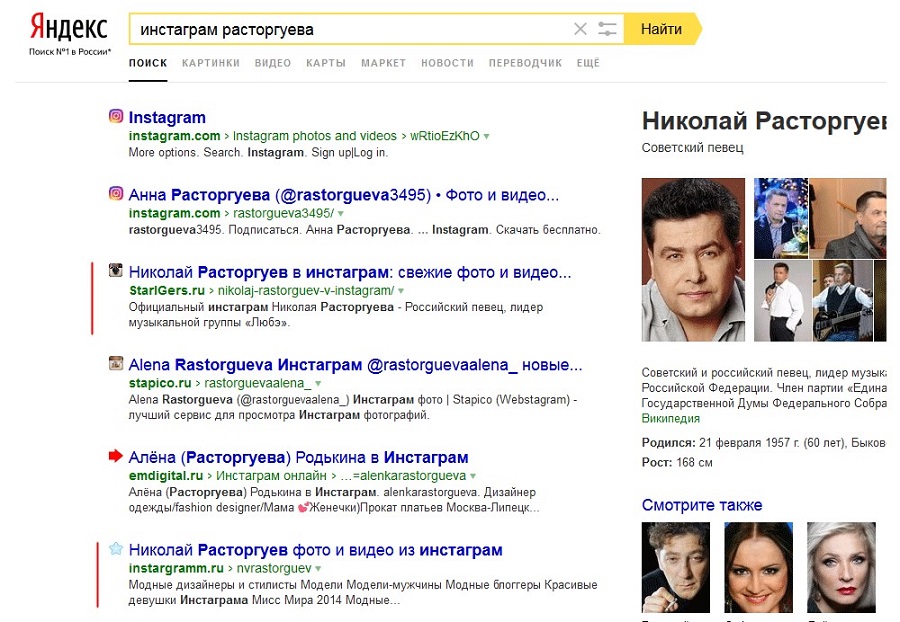

Клоны «инстаграма»

Поскольку сам «инстаграм» оптимизирован так себе, ему помогают неофициальные фанаты. Как вы понимаете, уникального контента там нет.

10. Уникальная добавленная ценность

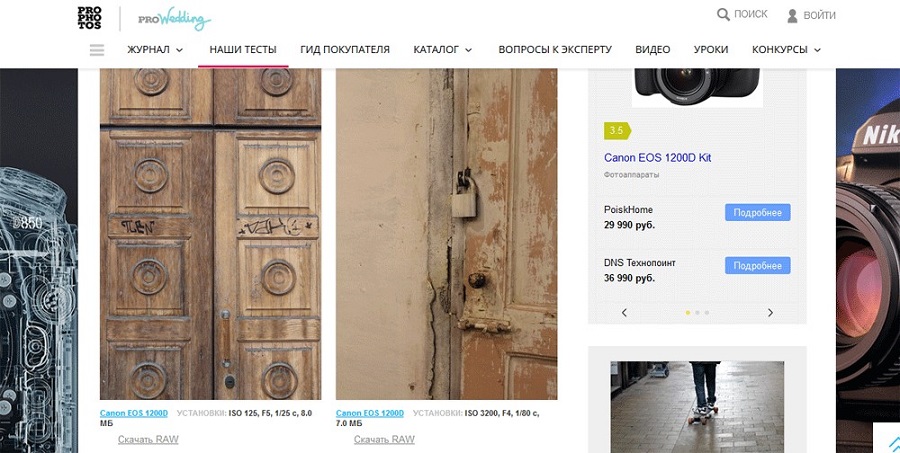

Все примеры № 1–9 можно свести к удобству, объему или объединению данных, без создания хоть какого-то значительного объема нового контента. Обратный пример – контент, который показывает данные в понятном большинству формате. Например, при выборе недорогой зеркалки мне ничего не говорили технические характеристики. Понятный для непрофессионала контент – это фотографии, сделанные на какую-то модель:

Это мне понятнее, чем оптические характеристики объектива

Эту страницу можно увеличить в разы, добавив неуникальный материал – технические характеристики, видеоролики с «Ютуба», снятые на эту модель, фото самого аппарата и т. д. – и это увеличит ее посещаемость.

В интернет-магазинах техники, где посетители могут голосовать за полезность отзыва, самые «залайканные» обычно обзоры от людей для людей, вроде «Купил такой ноут, 4 часа можно смотреть фильмы без подзарядки, на солнце не бликует, не греется». Попробуйте эти же данные узнать из технических характеристик.

Непоисковые риски при использовании неуникального контента

Хотя использование чужих материалов не несет прямых рисков бана или фильтра со стороны поисковых систем, особо рьяных копипастеров подстерегает другая опасность.

В поисковых запросах на русском со словом «бесплатно» лидируют приставки «скачать», «смотреть» и «онлайн». Это возможно благодаря практически нулевой грамотности насчет авторского права. В то же время, за один факт нарушения авторских прав (скопировать чужой сайт, чужой текст, чужое фото, видео) по закону РФ можно получить иск на сумму от 10 000 до 5 000 000 рублей.

Правовая практика по таким делам уже сложилась, уже можно легко получить иск на 200-300 тысяч, просто позаимствовав один чужой фотосет. В рунете полно нашумевших историй – «попадали» и владельцы сайтов, и хозяева пабликов «ВКонтакте». Бывали и миллионные иски к физлицам.

Удивительно, но несмотря на это полно еще непуганых вебмастеров, которые просто берут фотки в «Гугле» – а что, они же в открытом доступе. За последние 5 лет я на разных форумах неоднократно наблюдал эпичные топики на 40–50 страниц, всю суть которых можно свести к пяти этапам:

- Мне тут написали, что у меня чужие фото, хотят NNN тысяч.

- Адекватный комментарий юриста в стиле «попробуйте решить вопрос дешевле, но досудебно».

- 100500 комментариев диванных юристов «удали они не докажут», «берут на понт» и т. д.

- Бравирование автора топика – удалил, послал всех лесом.

- Повестка в суд, суд, автор топика реально должен выплатить NNN тысяч, или чуть меньше.

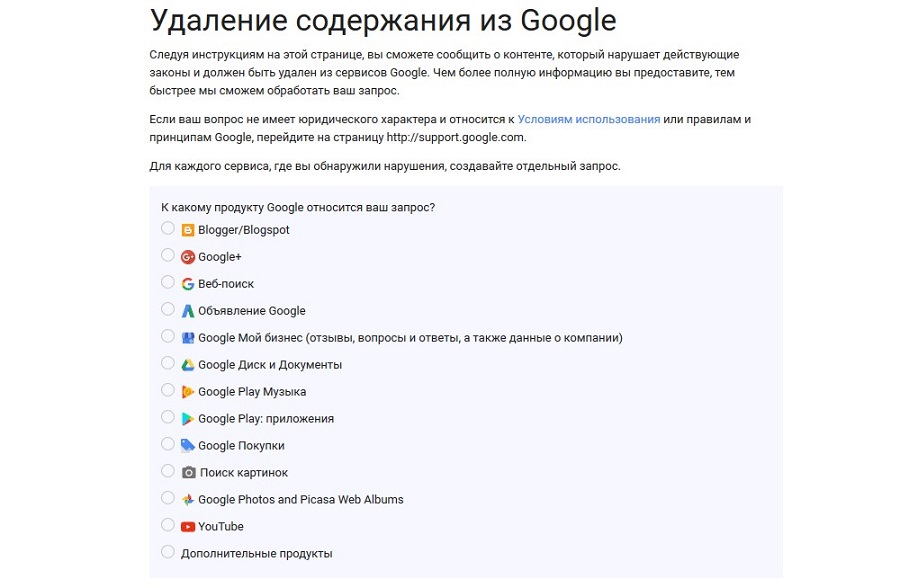

А для проектов, в которые вложены сотни тысяч долларов, штраф в 100 тысяч рублей за фото покажется сказкой, по сравнению с регулярным удалением контента по жалобе. Google предоставляет такой инструмент:

Интернет-магазин конкурента взял ваши фотки и вылез в топ? Подайте в суд и выкиньте его из выдачи Google.

Именно из-за рисков, связанных с авторскими правами, коммерческим проектам сложнее обойтись без уникального контента. Нет никакой гарантии, что за взятые «из интернетов» фото владелец сайт не получит через полгода иск на круглую сумму. А если это будет интернет-магазин, и фотографии будут скопированы не десятком, а тысячами?

Это же касается текста – выше в статье я приводил пример, где можно просто заменить название фирмы на свое. А после этого можно также «попасть» на круглую сумму, если этот текст собственноручно с буклета на сайт вносил менеджер конкурента, и это будет доказано в суде.

Я рекомендую вам пересмотреть свою политику работы с контентом сайта, особенно связанную с различными подрядчиками. Независимо от того, кто ведет ваш сайт, аккаунт в соцсети и т. д. – отвечать в суде будет владелец аккаунта или домена сайта.

Поинтересуйтесь, откуда берутся данные, добавляемые на ваш проект.

Выводы и чеклист

Для поисковых систем важна не уникальность контента, а удовлетворение интересов пользователя. Если данные не уникальны, но дают больше ценности, чем первоисточник – такой контент будет получать свою долю аудитории, возможно, большую, чем первоисточник.Чеклист:

- Если вы берете данные для своего проекта «из интернета» – убедитесь, что это или общедоступные данные, или автор разрешил их использование на определенных условиях.

- Важна польза, а не уникальность.

- Инструменты подтверждения авторства от поисковых систем не гарантируют сохранения первых мест выдачи первоисточнику.

- Если ваш контент растащили по разным сайтам без разрешения – можно или судиться, или выкинуть их страницы из Google.

- Если копипаст ранжируется выше первоисточника – значит, он чем-то лучше. Узнайте, чем и сделайте лучше свой проект.

- Затрудните воровство контента – водяные знаки на фото и видео. Фото – свои, которые бессмысленно воровать. Текст не должен быть обезличенным – ссылайтесь на другие материалы, упоминайте «фишки», которые есть только у вас.

- В популярных нишах уникальность контента падает не только из-за воровства. Когда про новый айфон 50 статей, их уникальность будет выше, чем когда их будет 50 000.

- Проверьте материалы вашего сайта – нет ли риска получить судебный иск за изображения в блоге компании или на главной странице?

- Создайте политику работы с контентом, исключающую нарушение чужих авторских прав, и требуйте ее соблюдения от сотрудников и подрядчиков.

- Может получиться так, что вы не сможете заставить чужой сайт убрать ваш контент. Не унывайте. Гораздо больших результатов можно добиться, развивая свой проект, а не гоняясь за теми, у кого текст на 10 % совпал с вашим.

Автор: Дмитрий Скалубо

Источник: https://texterra.ru/blog/issledovanie-deystvitelno-li-unikalnost-kontenta-tak-vazhna.html

Admin- Admin

- Дата регистрации : 2016-02-14

Сообщения : 836

Репутация : 17

Похожие темы

Похожие темы» Как использовать чеклисты при создании контента

» Исследование: как читают пользователи в Интернете?

» Исследование аудитории онлайн-покупателей в России

» Топ-10 трендов маркетинга на 2024 год: исследование VML

Инфопортал Гильдии Маркетологов :: Новости и обзоры :: Актуальные публикации для маркетолога и рекламиста :: Результаты исследований, обзоры рынков

Создать

Создать Новости

Новости Форум

Форум События

События Викистатьи

Викистатьи Регистрация

Регистрация Вход

Вход